Zhang Wohao

Zhang Wohao

长度256

请问是否可以设置最大长度为1024吗,大概需要多少资源可以训练呢

### 详细描述问题 我使用转换为hf的原版Facebook的LLama权重和本库开源的中文LLama lora合并得到中文LLama模型,由于我想要得到准确的答案,我的解码参数是num_beans=4,early_stopping=True,模型产生了重复的回答;在加入repetition_penalty=2后,回答发生错误。我想将该中文LLama模型作为领域微调的基座模型,但对该中文LLama模型的目前效果感到担忧。 ### 运行截图或log num_beans=4,early_stopping=True  在加入repetition_penalty=2后,回答发生错误  ### 必查项目 - [x] 哪个模型的问题:LLaMA - [x] 问题类型: - 模型转换和合并 - 模型推理问题(🤗 transformers) - 效果问题 - [x] 我已阅读[FAQ章节](https://github.com/ymcui/Chinese-LLaMA-Alpaca/wiki/常见问题)并且已在Issue中对问题进行了搜索,没有找到相似问题和解决方案

### Is there an existing issue for this? - [X] I have searched the existing issues ### Current Behavior 请问 chatGLM-6b 用的那种P-tuning v2 应该是属于参数高效微调的一种, 那也是微调的一种, 可以用来指令微调吗 ### Expected Behavior _No...

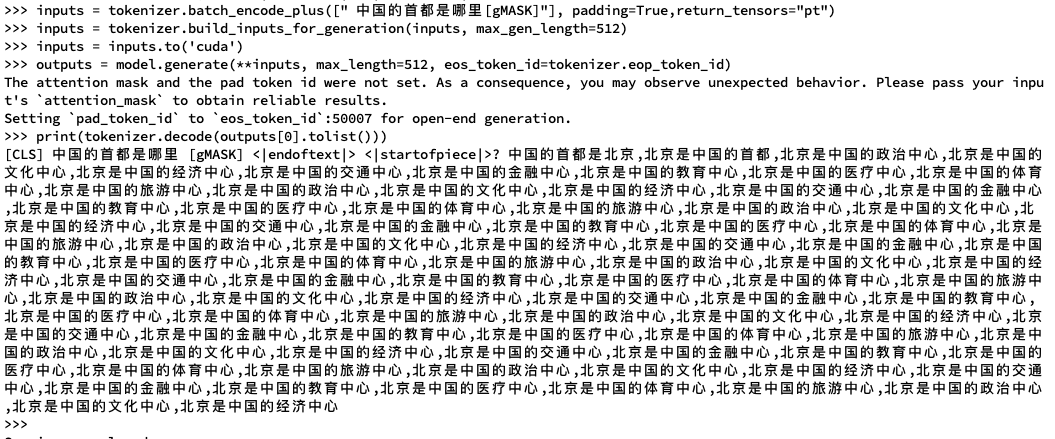

如图所示,我按照示例进行inference,出现了重复生成问题。这是因为设置不对吗?

**Is your feature request related to a problem? Please describe.** 1. I want to do retrieval-based QA on a docx document where the document contains text and tables, how do...

### 🚀 The feature, motivation and pitch Hello, I'm encountering a similar issue #73 . I'm parsing a PDF converted from a Word document. The hierarchical headings are not being...