tomtang110

tomtang110

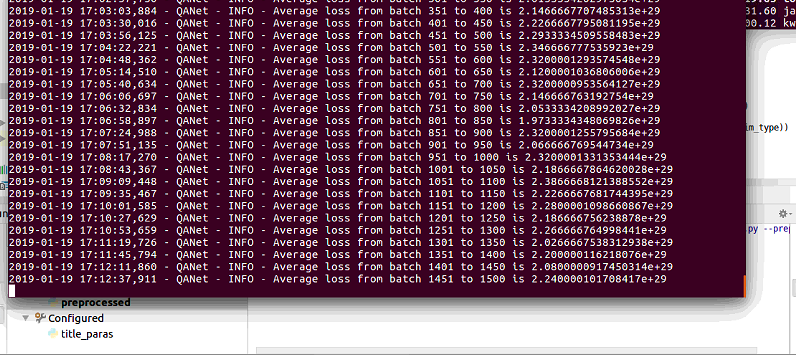

why the loss is so huge?

loss在某一部分数据变得异常大,最后导致验证集所有分数为0. 请问,是怎么产生的呢?

你好,发现predict,无法把所有数据完全预测,跟batch_size的倍数有关。如果无法满足batch_size倍数,无法完全预测

### Is there an existing issue for this? - [X] I have searched the existing issues ### Current Behavior 我的显卡是Tesla T4,16gb显存,在train.sh上finetue,用的是你们提供的数据集共54mb大小,训练的时候发现,速度实在是太慢了,3000个step需要7小时。试了下eval.sh发现需要2个小时推理完整个验证集,我想是不是哪里的参数没有调对,实在太慢了。 ### Expected Behavior 希望给一个快速训练的方案,看是不是哪里参数配置错误了。如果不是参数错误,可以给一个正常推理和训练速度的显卡配置吗?54mb的数据要7个小时才能训练完,实在是太慢了。 之前用llama 1.3b微调数据也就15-20分钟,20mb的英文数据,就训练完毕了。 ### Steps To...

在租的服务器上跑代码,它启动就是一个docker,用的之前你们的环境,发现无法run代码了?

在训练的时候,运行bash training_scripts/single_gpu/run_FT.sh命令,直接什么错误都不报,但是,无法运行,显存看加载了一点,然后程序就死了。 运行bash training_scripts/single_gpu/run_LoRA.sh 的时候,  z在这个地方卡死不动了。  最后这里报错了

Hi I attempt to change the sigmoid in tower layer to softmax, and the loss is the crossentropy, to my surprise, the auc of income cannot be decreased only 0.54....

对于树中第j层的每个非叶子节点的概率等于其子节点的概率的最大值除以正则项 α(j) ,这样能保证在任何一层查找概率较大的 k 个节点后,其下一层概率较大的 k 个节点均属于上一层这 k 个节点的子节点。而正则项的引入,是用于调整 P(j)(n|u) 的大小,保证同一层中各节点的概率和为1。论文中将满足这一特性的树结构称为最大堆树(Max-heap like tree)。  这个是没有的把,这样就就无法保证beam search找到最优解

Could you explain why you add self.vocab_size between question id and answer id?