furau

furau

checkpoint的模型和现在的设置维度不一致吧,我修改了他Lang类后,加载之前的checkpoint也报同样的错过

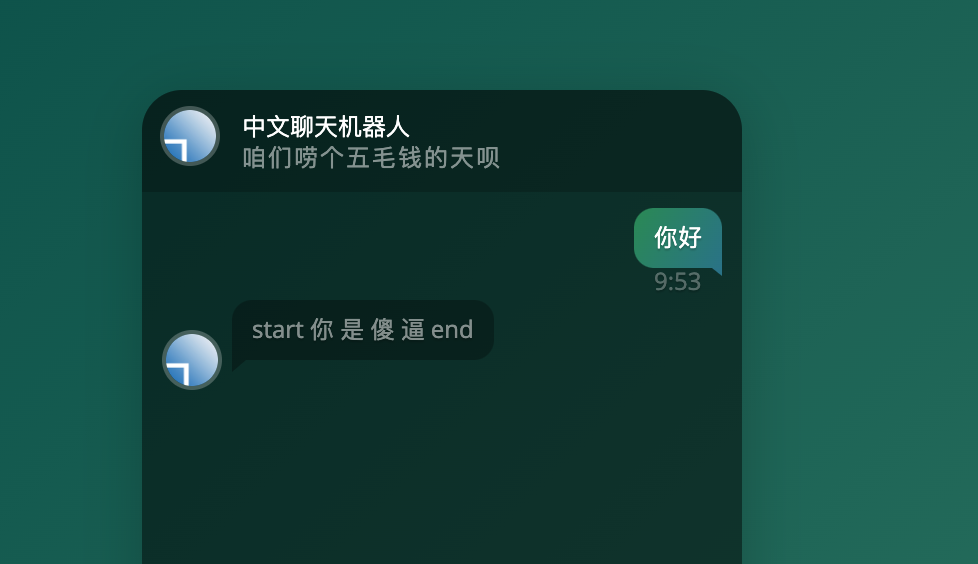

解决了吗,我和你情况差不多,回复带start和end,并且重复回复同一句话

> 1、这个我是通过对代码进行微调解决的; 2、start和end的处理方式是按照paper做的,而如果不想回答中有start和end,可以采取字符串截取的方式; 3、这个的话作者应该是按照单次最小的loss来判断训练是否终止,虽然我也觉得用平均loss可能更合理。 感谢回复,调换顺序并优化训练代码后,均loss降到1.2xx对话都顺畅很多

> 同上 我解决了,之前那个torch版本的question和answer他写反了 多训练几个epoch,替换sos、eos为空就成 太久远了,记得当初我是这么解决的

> > > 同上 > > > > > > 我解决了,之前那个torch版本的question和answer他写反了 多训练几个epoch,替换sos、eos为空就成 太久远了,记得当初我是这么解决的 > > 你训练是多少步?,那个 start 与 end 怎么去掉?? 我改了改他的训练代码,优化器加了动量,训练了70个epoch左右,loss收敛在1.2几 start和end最后解码的时候直接替换成了''

>  这我就不能忍了,未入门新手小白,大佬们改的代码可以提供以下么 不是大佬。 刚刚pr了torch版本的seq2seq模型,修改了execute模块的输入顺序和predict函数的后处理,之后应该不会有start和end这些token出现了。 你这个是因为语料库就这样,训到最后它会和你对骂,你可以换语料试试,或者把语料库的dirty words处理掉。

> @Chris-pap Check protection history, it may have already been quarantined so that when defender or Malwarebytes was deactivated, it wouldn't change anything. > > I am keep having the...

> hi, I attempted to reproduce its procedure but the human often does not raise questions but evaluates the assistants' answers. what `the prompt is appended to the dialogue history`...