randaller

randaller

@breisig It is possible, if your raw excel data or php code size around 2-3-4 kilobytes (2048 tokens).

Still same problem, X/Y generates the same image like the first sampler.

Да, есть такая проблема, сервер на Windows 10 x64, отключение μTP в настройках сервера помогает. Но, как следствие, в kodi с плагином rutracker пропадает отметка просмотренности серии, и перестаёт работать...

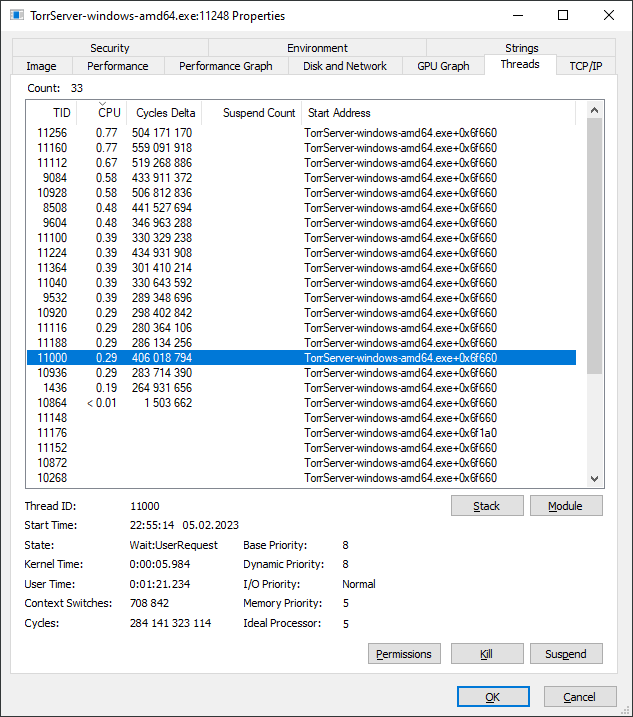

Да, проблема сохраняется в 1.20, похоже, что горутины, примерно по количеству сидеров торрента, что-то делают после отключения клиента коди.

На тв-боксе на ARM такое же поведение у сервера 1.20, а процессор-то слабенький, в плеере проявляется как периодическое подлагивание картинки раз в несколько секунд.

Successfully running LLaMA 7B, 13B and 30B on a desktop CPU 12700k with 128 Gb of RAM; without videocard. https://github.com/randaller/llama-cpu

@Marcophono2 in a file https://github.com/facebookresearch/llama/blob/main/llama/generation.py#L65 after the 65'th line insert ``` if d.endswith("User:"): return [decoded[0][:-5]] ``` where 5 is a length of a given string "User:" that stops output

@Marcophono2 this will not stop generation till it's end in this original repo, but it will return generation that ends with your match. But with your inference speed it's ok...

Yes I did, but you need a lot of RAM. https://github.com/facebookresearch/llama/issues/79#issuecomment-1460464011

Run it on home desktop PC: https://github.com/randaller/llama-chat