bixiaopeng

bixiaopeng

训练

请问你尝试过调参吗,有没有大的提升?

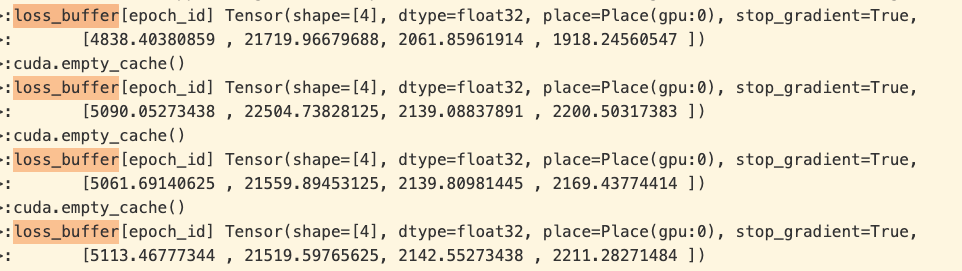

### 请提出你的问题 Please ask your question 我想同步每张卡上loss_buffer,每次只是同步某一行。但是同步之后,每张卡打印出来的变量不一样,是为什么呢? 代码和打印log如下: loss_buffer = paddle.zeros(shape=[100,4]) #[epoch,loss_num] paddle.distributed.barrier() paddle.distributed.all_reduce(loss_buffer[epoch_id]) print("loss_buffer[epoch_id]",loss_buffer[epoch_id])

### 问题确认 Search before asking - [X] 我已经搜索过问题,但是没有找到解答。I have searched the question and found no related answer. ### 请提出你的问题 Please ask your question 请问torch优化器中的optimizer.param_groups,在paddle对应哪个api呀?

### 问题确认 Search before asking - [X] 我已经搜索过问题,但是没有找到解答。I have searched the question and found no related answer. ### 请提出你的问题 Please ask your question 1、训练时显存利用率不高 在私有数据集上训练yolox_m 在四卡p40上,平均每张卡bs=4,利用率为70%,显卡利用率不高,而且每张卡上的显存波动比较大。 2、eval私有数据集时,显存利用率绝大时间为0%,评测指令为 `export CUDA_VISIBLE_DEVICES=0,1 #windows和Mac下不需要执行该命令...

多batch推理

**请将下面信息填写完整,便于我们快速解决问题,谢谢!** **问题描述** 请在此处详细的描述报错信息 ppyoloe支持onnx batch>1推理么,如果不支持,具体是为什么呢? **更多信息 :** - 用于部署的推理引擎: - 为什么需要转换为ONNX格式: - Paddle2ONNX版本: - 你的联系方式(Email/Wechat/Phone): **报错截图** **其他信息**

Could you provide a training environment? thanks

### 问题确认 Search before asking - [X] 我已经搜索过问题,但是没有找到解答。I have searched the question and found no related answer. ### 请提出你的问题 Please ask your question 训练DINO-VIT hang住,log里面没有发现报错信息,显卡这里有三张利用率100%,另外一张利用率为0 请问可能是什么原因呀?

首先在高通cpu版本已跑通demo,当在高通gpu版本运行的时候,遇到如下问题 1、转换opencl nb文件提示log如下 2、opencl版本sdk 程序结束时异常报错,cpu版本不会,提示错误如下 3、输出信息错误 当前模型有多个head,其中head a输出精度差异在小数点2位,head b输出完全不对