Donaghys

Donaghys

能不能加个联系方式相互学习下啊?兄弟,我看这个项目这两天就是咱们活跃了~~~~我的vx18832031363

> 你们也是做识别吗,可不可以加个联系方式 共同学习~~~~欢迎

> @whwme > 这个是在瓶颈出现在读数据上面,可以改变一下读数据的方式,可以快1倍以上的速度,我16G内存,4G显示,Batch_size, 128,一个epoch大概 5000秒,看作者的,200张图像/s,我没有用prefecter技术之前大概是320张图像/s。用了之后750张/s。如果内存够大,你可以把batch_size 增大。 > >  > 修改lib/core/function.py > 整个文件都修改了。 > 代码如下: > ` > """ > 利用了prefetcher技术,连计算的同时也在读取数据 > 虽然现在GPU利用率比之前还低,但处理速度,比之前快了一倍 > 缺点:内存占用比之前多一倍 > """ > >...

速度是快了不少,但是loss降不下去,平时最终在0.0005收敛,现在在0.6就收敛了,有好的解决办法吗?

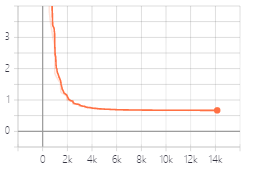

> 这个不会影响模型的,这只是dataloader会快一点。你可以测试一下准确率看看效果。 感谢您的工作,同样使用作者提供的预训练模型finetune,如果我不使用prefecter,我的数据一个bs后就可以到2.多,只需要2-3个epoch就可以下降到很低,大约在0.005左右,验证集有90%以上的准确率,但是速度在500/s张左右,加入这个prefecter后,速度到了3100/s,但是这个损失就下降的很慢,现在已经30个epoch了,损失依然是0.6,曲线如刚才发的样子,我现在怀疑网络已经收敛了~,但是除了这个dataloader以外,我没有对代码做任何修改,我很困惑,希望得到您的指点~

> 这个不会影响模型的,这只是dataloader会快一点。你可以测试一下准确率看看效果。这个跟原来的没有什么区别,区别是是加了prefecter技术,读数据时候快点。应该不影响到loss还有准确率的。你可以对比一下两个模型的效果。 主要还是mode(inp),以前是cpu做预测,您这是gpu做预测~,两者会不会有差距呢?

刚开始也是这样子,后来就好很多了

> _No description provided._ 我也想知道,为什么要使用cpu,如果改成mode(inp)的话非常影响网络最终的训练结果~我这边,前期loss能差两个数量级

> 代码里面在把数据传入LSTM网络的时候把batch_size变换到了第1维(0开始),DataParallel默认按照第0维进行拆分和拼接。 > > 所以第一种方法可以临时修改DataParallel中gather函数传入的参数dim改成1,即可解决,但是跑别的代码要记得改回来。 > > 另一种方法可以将模型的最后输出batch_size改到第0维,这样并行就会按照batch_size拼接,然后再变换到第1维。(从代码中看的话传入CTC损失函数的batch_size是第1维) 请问有没有试过预测的时候改成GPU训练?

> > tf.app.flags.DEFINE_boolean('restore', True, '') > > set the 'True' to 'False',and you can run > > Thanks,this solve my problem,thanks again An error appears after running AttributeError: Can't pickle...