MixMIM

MixMIM copied to clipboard

MixMIM copied to clipboard

MixMIM: Mixed and Masked Image Modeling for Efficient Visual Representation Learning

预训练权重

非常感谢您的研究,正在深入您的研究内容,请问是否能提供预训练权重,感谢!

模型预训练权重

你好,请问可以分享一下MixMIM以Swin-B作为backbone在预训练过程中得到的权重吗?包括Swin-B编码器的权重和Transformer解码器的权重,非常感谢!

代码小错误

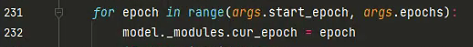

在运行代码的过程中发现了两个小错误 add_weight_decay ——> param_groups_weight_decay  module ——> _modules

请问在下游任务上收敛速度比imagenet权重要慢很多是正常的吗,, ? 还有复现来看,感觉和simmim并没有明显的差距呢

请问,我在win系统下,from petrel_client.client import Client提示无法解析导入“petrel_client.client”,这个问题怎么解决? 安装也找不到这个库

Training with the default Settings, gradients always appear inf, is it normal?

hi,我注意到模型的attention部分存在 masked self-attention计算,如果用到原始swin中,它里面shifted window也会存在一个mask计算, 是不是会重叠不好部署呢?

请问替换为其它backbone还需要加上absolute_pos_embed位置编码吗,因为我看SimMIM也采用swin,但是没有加absolute_pos_embed, 而且最新的一些transformer设计都已经用conv卷积来替换绝对位置编码了