请问最后得到的loss曲线中的val box loss为什么是上升趋势呢

因为过拟合了,数据集中没有测试集

因为过拟合了,数据集中没有测试集

根据作者给的数据集划分文件划分了训练集和验证集,还得划分测试集吗

你好,请问这个问题解决了吗?是由什么问题造成的?

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

好的,如果你在训练结束后对此有想法的话,非常期待和你的交流

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

您好,请问您有新的想法吗,为什么会上升,该怎么解决呢,谢谢

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

您好,请问您有新的想法吗,为什么会上升,该怎么解决呢,谢谢

你用的数据集和模型分别是多大的,会不会是数据集太小,模型太大?我的数据集是1935张,按7:2:1的比例进行了划分,用了yolov5l模型,我打算用yolov5s试一下

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

您好,请问您有新的想法吗,为什么会上升,该怎么解决呢,谢谢

我看了一下results.txt,发现val box loss图的趋势和[email protected]很像,倒数第三列倒像loss趋势却没有画出来,这里是不是画错图了

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

您好,请问您有新的想法吗,为什么会上升,该怎么解决呢,谢谢

你用的数据集和模型分别是多大的,会不会是数据集太小,模型太大?我的数据集是1935张,按7:2:1的比例进行了划分,用了yolov5l模型,我打算用yolov5s试一下

用的是flir和llvip数据集都会出现这个问题,训练集验证集划分是按照数据集文件夹里划分好的

你好,请问这个问题解决了吗?是由什么问题造成的?

还没找到原因,请问你对此有什么想法吗

抱歉,目前还在训练中,结束后我才能根据结果对该问题提出一些想法

您好,请问您有新的想法吗,为什么会上升,该怎么解决呢,谢谢

我看了一下results.txt,发现val box loss图的趋势和[email protected]很像,倒数第三列倒像loss趋势却没有画出来,这里是不是画错图了

我发现用tensorboard的可视化的话objloss会上升

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

我觉得可以试一试,但不敢保证一定管用

------------------ 原始邮件 ------------------ 发件人: @.>; 发送时间: 2023年10月5日(星期四) 晚上9:38 收件人: @.>; 抄送: @.>; @.>; 主题: Re: [DocF/multispectral-object-detection] 请问最后得到的loss曲线中的val box loss为什么是上升趋势呢 (Issue #59)

那把cache文件删掉重新训练一次吗

发自我的iPhone

------------------ 原始邮件 ------------------ 发件人: nlynzb @.> 发送时间: 2023年10月5日 21:34 收件人: DocF/multispectral-object-detection @.> 抄送: mtdyhhxxttxs @.>, Comment @.> 主题: Re: [DocF/multispectral-object-detection] 请问最后得到的loss曲线中的val box loss为什么是上升趋势呢 (Issue #59)

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

— Reply to this email directly, view it on GitHub, or unsubscribe. You are receiving this because you commented.Message ID: @.> — Reply to this email directly, view it on GitHub, or unsubscribe. You are receiving this because you commented.Message ID: @.>

今天我换了一个小型数据集完成了训练,但是在result.png上仍然存在val_box loss上升的问题,但是我在tensorboard打开log文件却发现一切都是正常的,(图不知道怎么放上去),也许是什么地方出现了错误导致画图有问题。

今天我换了一个小型数据集完成了训练,但是在result.png上仍然存在val_box loss上升的问题,但是我在tensorboard打开log文件却发现一切都是正常的,(图不知道怎么放上去),也许是什么地方出现了错误导致画图有问题。

是的,我打开tensorboard结果也是正常的,应该是result.png画图有问题

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

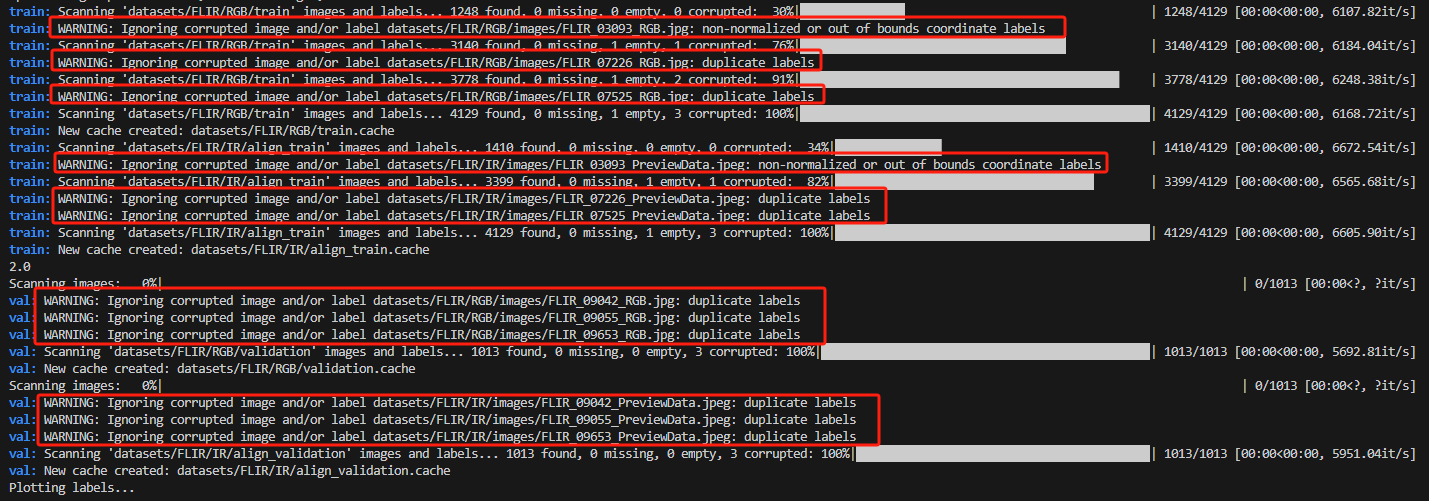

您好,想请问一下您说的读取数据出错,那下面的这种情况下有warning,算读取出错吗

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

您好,想请问一下您说的读取数据出错,那下面的这种情况下有warning,算读取出错吗

我看了一下,在红框下面数据是有被成功读取的(注意看一下读取的数据是否完整,比如你的训练集是否为4129),新的cache也被创建,所以这个警告可以忽略,对最后的result.png有疑问最好是根据自己训练生成的log文件去tensorboard查看训练和验证曲线,希望以上对你有所帮助

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

您好,想请问一下您说的读取数据出错,那下面的这种情况下有warning,算读取出错吗

我看了一下,在红框下面数据是有被成功读取的(注意看一下读取的数据是否完整,比如你的训练集是否为4129),新的cache也被创建,所以这个警告可以忽略,对最后的result.png有疑问最好是根据自己训练生成的log文件去tensorboard查看训练和验证曲线,希望以上对你有所帮助

好的,感谢感谢🙇

我在训练后也出现了val_box loss上升的情况,后来在我重新训练的时候我注意到了一个小细节,当我们第一次运行train.py文件时,如果程序在读取数据后出错(已经生成了cache文件),当我们更改错误并再次运行train.py文件时会发现,程序读取的数据出现了问题,它会显示scanning rgb和ir图像的路径是相同的(train和val都是),也就是说我们这次训练的数据是同一模态的两对数据,存在大量的相同数据,我想也许是这种情况导致我们最后的结果过拟合,当然,上面只是我的推测,再次训练出结果后才能确定是否正确。

您好,想请问一下您说的读取数据出错,那下面的这种情况下有warning,算读取出错吗

我看了一下,在红框下面数据是有被成功读取的(注意看一下读取的数据是否完整,比如你的训练集是否为4129),新的cache也被创建,所以这个警告可以忽略,对最后的result.png有疑问最好是根据自己训练生成的log文件去tensorboard查看训练和验证曲线,希望以上对你有所帮助

您好,请问你有在flir数据集上训练过吗,我训练flir数据集的时候,objloss也会上升